Robin Bedrunka 🐞

fabia_man@mamutovo.cz@vitex Já jsem tu první variantu bral jako vtip, ale čím dál častěji tohle vidím, nabiram dojmu, že takhle snad někdo opravdu programuje. 😁

Chao-c'

xChaos@f.cz@fabia_man z hlediska low-end vývojářů, který fakt rozuměj tomu, jak věci fungujou "pod kapotou", takhle programujeme asi všichni... @vitex

Marián Kyral

mkyral@mastodonczech.cz@fabia_man @vitex Takhle nikdo neprogramuje, takhle se akorát prasí.

Jan Helebrant

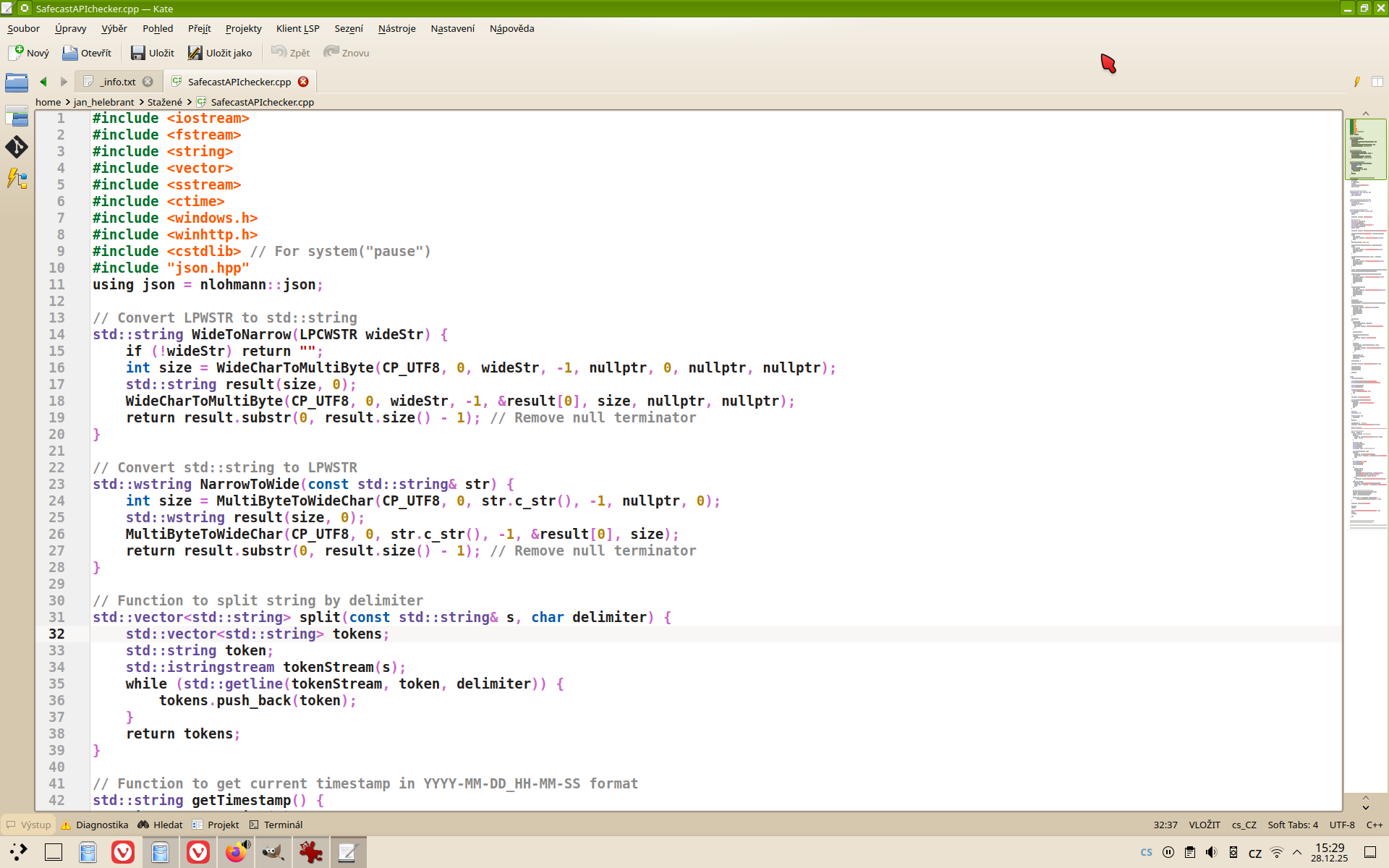

juhele@cztwitter.cz@mkyral @fabia_man @vitex tak to teda asi "prasím" oldschool stylem, protože kód napsat neumím, ale zhruba zkouknout si to dokážu a (občas s jistou dopomocí AI) i zkompilovat...

PS: programovat jsem se v životě neučil, k tomuhle prasení mne dohnala spíš nouze...

Marián Kyral

mkyral@mastodonczech.cz@juhele @fabia_man @vitex Pořád lepší než to co bylo na obrázku 😉

Robin Bedrunka 🐞

fabia_man@mamutovo.cz@xChaos Není to nadsázka? Funkce a programy by měly být univerzální, i v JSI přece nebudeš vyhodnocovat takto. 🤔

Chao-c'

xChaos@f.cz@fabia_man ok, směješ se někomu, kdo nezná operátor %, zbytek po dělení... ale jak často používáš třeba >> nebo << k násobení či dělení dvěma? Pokud pracuješ s polem pravdivostních hodnot, dáš si práci s bitovou maskou nebo se spokojíš s polem integerů? Atd. atd.

Software byl "bloated" vždycky a tendence k řešení problému výčtem speciálních případů místo nalezením algoritmu byla vždycky. Mě samozřejmě offloading směrem k AI přijde absurdní, ale narážka na to, že před AI jsme programovali taky často dost hloupě, je na místě.

Le Papier Blanc

lepapierblanc@mastodonczech.czTím low-end se asi myslí programování bez compileru.

My ostatní se spolehneme na „chytrost“ compileru a jeho optimalizaci pro specifický HW.

Ozzelot

ozzelot@mstdn.social

@lepapierblanc

Programování bez compileru?

*Diogenes vytahuje Python*

@fabia_man @xChaos

Chao-c'

xChaos@f.cz@fabia_man no tak ano, vývojáři se znalostí reprezentace čísel v paměti se podívaj na poslední bit, ti ostatní se využijou zbytek po dělení :-)

Dilema spíš zní, jestli dělat to základní "general purpose computing" hloupě, nebo ho nedělat vůbec.

Uživatelé vyšších programovacích jazyků nad tímhle stejně nikdy moc nepřemýšleli (ale to neznamená, že by byli hloupí - prostě řeší jinou kategorii problémů). Podle mě by se na to nejspíš stejně zeptali nějaké knihovní funkce (jako já používám třeba isalnum(), místo abych složitě přemýšlel nad třemi rozsahy, kde jsou v ASCII čísla a velká a malá písmena... přitom ani klasické isalnum() nejspíš nereaguje na locales....)

Pointa může být i ta, že stochastický papoušek je to u řady čísel schopen vyhodnotit špatně, protože vlastně proč ne: čísla bude stejně reprezentovat pomocí tokenů a s těmu se mi špatně pracuje (jestli LLM může do budoucna něco vylepšit, tak vhodná a nikoliv čistě statistická tokenizace, ale podle mě je to stejně ztracené...)

Robin Bedrunka 🐞

fabia_man@mamutovo.cz@xChaos Proč já se vždycky do těch diskuzí tady pouštím, nevím, opravdu.

Chao-c'

xChaos@f.cz@ozzelot @lepapierblanc @fabia_man pche, compilery a interpretery jsou minulost, teď se bude přímo promptovat... žádný klávesnice, mikrofony přpojený přímo ke grafickým kartám, který budou mít nožičky a přijdou se zeptat.

Spotřeba energie bude sice exponenciálně vyšší, ale aspoň se zbavíme chytráků, který si mysleli, že jejich porozumění von Neumannově architektuře Turingových strojů z nic dělá nadlidi.... on wait.

Ozzelot

ozzelot@mstdn.social

@xChaos @lepapierblanc @fabia_man a co muselo být použito, aby se ty grafické karty mohly ptát? neptejte se, to je zločin

Chao-c'

xChaos@f.cz@ozzelot to bude zapomenuté tajemství pradávných civilizací :-) grafické karty se budou samy přímo nějak množit, předpokládám. A nikdo nebude vědět, jak fungují uvnitř.

Pavel Machek

pavelA pole integeru bude casto rychlejsi nez bitova maska :-).

Chao-c'

xChaos@f.cz@pavel @fabia_man jo, co se týče rychlosti, to asi jo.

Ale obecně, přijde na to, kdo k tomu počítači sedne. Operátor zbytku po dělení podle mě není součástí takové té "základoškolské" matematiky. Otázka je, jak často v reálném případě potřebujeme vědět, jestli je číslo liché (pokud zrovna negenerujeme nějaké zkrášlenou HTML tabulku, kde liché buňky mají být vlevo a sudé vpravo).

Jakkoliv jsem k AI spíše skeptický, tak by bylo dobré si připustit, kolik věcí v programování se děje prostě proto, aby někdo předvedl, že to umí - a někdo jiný to pak okopíruje, protože mu to přijde buď jako dobrý nápad, nebo chce předvést, že to umí taky.

AI je nevyhnutelným vyústěním trendu, kdy grafické rozhraní se vnutilo všemu, bez ohledu na to, jestli je to výhodné, a kdy HW nároky na v podstatě triviální funkčnost vzrostly ad absurdum. Je to podle mě určitý trest za to, že se programovalo soustavně špatně, ale nejen to: architektura celý systémů byla soustavně špatná. Navrstvilo se toho moc a lidi, kteří na to upozorňovali a navrhovali jednoduchá řešení, se ocitli úplně mimo hlavní proud.